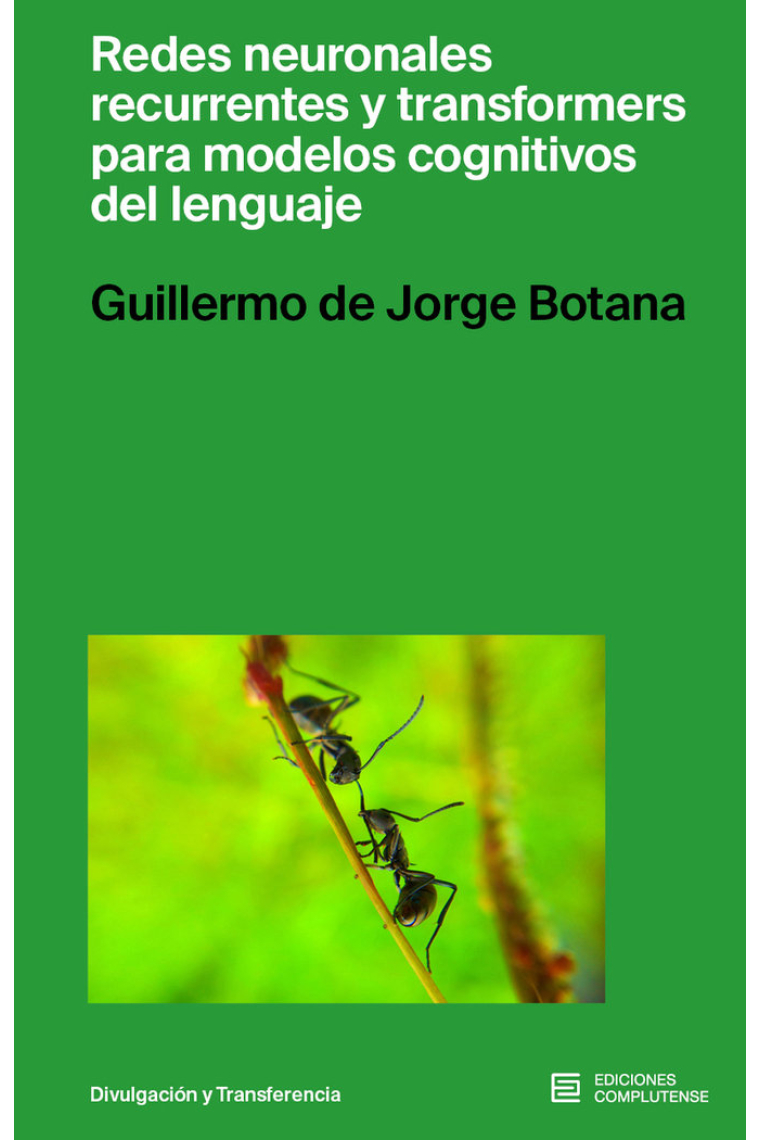

Detalles del libro

Los Grandes Modelos del Lenguaje han inundado muchos ámbitos en los que nos desenvolvemos. Raro es el que no haya puesto a prueba los modelos GPT 3.5/4, o no haya requerido la ayuda de chatGPT. Pero, ¿cómo hacen para generar estas respuestas?. Por debajo de todo ello se encuentran los algoritmos de aprendizaje profundo, en especial las redes neuronales artificiales de última generación. Este libro se dedica a las más destacadas en la construcción de estos modelos: las Redes Neuronales Recurrentes (RNN-LSTM) y los Transformers. Existen muchos videos y páginas web dedicadas a programar o usar, con pocas líneas de código, un modelo basado en RNN-LSTM o en bloques Transformer.. Se pretende que los que están aprendiendo a usarlas sepan entenderlas de manera exhaustiva y no ser el mero ejecutor de unas líneas. Esto ayudará a diseñar mejores entornos y no menos importante, a explicarlos y comunicarlos. Además, para poder homologar comportamiento artificial con comportamiento humano, el tratamiento de la argumentación del libro está orientado hacia la Ciencia Cognitiva.

Ver más - Encuadernación Tapa blanda

- Autor/es De Jorge Botana, Guillermo

- ISBN13 9788466938365

- ISBN10 8466938362

- Páginas 317

- Año de Edición 2024

- Idioma Castellano

Redes neuronales recurrentes y transformers para modelos cognitivos del lenguaje

- Guillermo De Jorge Botana

- ISBN 9788466938365

14,25€

15,00€

-5%

Disponible

14,25€

15,00€

-5%

Disponible

¡Disponible! Recíbelo en 24/48h

Gratis a partir de 18 €

en España peninsular

Recogida en librería

Gratis

¡Disponible! Cómpralo ahora y recógelo mañana.

¡Gracias por comprar en librerías reales!

¡Gracias por comprar en librerías reales!

Habla con tu librera

¿Necesitas ayuda para encontrar un libro?

¿Quieres una recomendación personal?

Lo mejor de diciembre

Lo mejor de diciembre

Alibri Llibrería, Barcelona

Alibri Llibrería, Barcelona

Librería Lé, Madrid

Librería Lé, Madrid

Caselles Llibrería, Lleida

Caselles Llibrería, Lleida